etl是什么?盤點十款開源的etl數據抽取工具

作者: 數環通發布時間: 2024-10-28 14:04:38

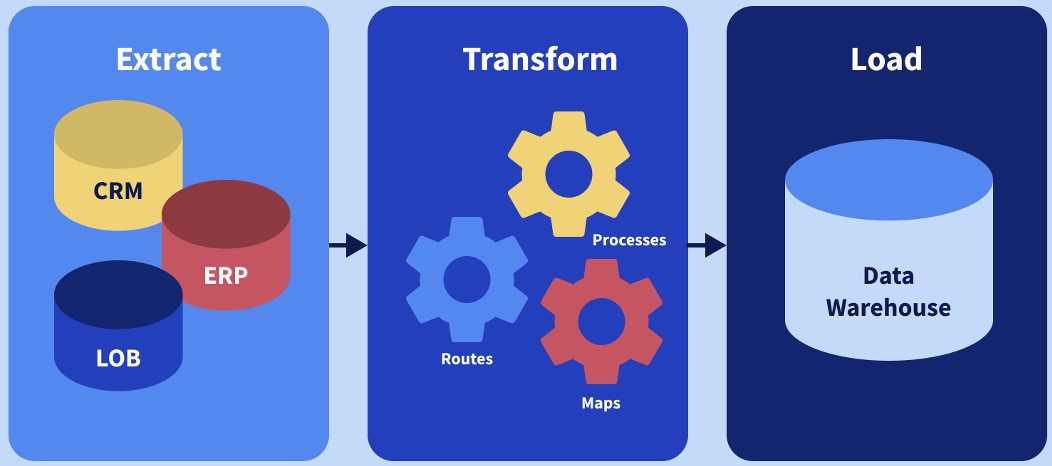

ETL是數據倉庫系統中的一個重要過程,它代表了數據抽取(Extract)、數據轉換(Transform)和數據加載(Load)三個階段的縮寫。

以下是對ETL的詳細講解:

一、ETL的定義與原理

ETL的原理是指在數據倉庫建設中,通過抽取數據源的數據,進行清洗、轉換和加載,最終將數據加載到數據倉庫中,為決策支持提供高質量的數據。它是數據整合解決方案中的關鍵環節,用于將分散、零亂、標準不統一的數據整合到一起,形成一致的數據視圖。

二、ETL的組成部分

數據抽取(Extract)

數據抽取是ETL過程中的第一步,目的是將不同數據源中的數據提取出來,為后續的數據清洗和轉換做準備。

數據源可能來自不同的數據庫、文件、應用系統或互聯網等多種渠道。

數據抽取可以通過數據庫連接、文件傳輸、API接口等方式進行,確保數據的完整性和準確性。

數據轉換(Transform)

數據轉換是ETL過程中的核心環節,涉及數據的清洗、整合、轉換等操作,以滿足數據倉庫的需求。

數據轉換可能包括數據的格式轉換、數據的合并、數據的計算等操作,以確保數據的一致性和可用性。

數據轉換也是保證數據質量的重要環節,通過數據清洗、去重、糾錯等操作,提高數據的質量和準確性。

數據加載(Load)

數據加載是ETL過程中的最后一步,將轉換后的數據加載到數據倉庫中,供用戶進行查詢和分析。

數據加載的方式有全量加載和增量加載兩種。全量加載是指將所有數據一次性加載到數據倉庫中,適用于數據量較小的情況;而增量加載是指只加載發生變化的數據,適用于數據量較大的情況,可以提高數據加載的效率和速度。

三、ETL的特點與優勢

自動化與效率提升:

ETL工具可以自動執行數據提取、轉換和加載的全過程,減少了人為干預,提高了處理速度。

通過自動化流程,ETL工具能夠顯著提高數據處理的效率,節省大量的人力和時間成本。

數據質量與準確性:

ETL工具通過一系列轉換操作,對數據進行清洗和標準化,確保數據的準確性和可靠性。

數據清洗包括去除重復數據、填補缺失值、糾正錯誤等,確保數據分析結果的準確性。

靈活性與可擴展性:

ETL工具通常支持多種數據源和目標系統,可以根據企業的具體需求進行定制和擴展。

隨著業務的發展和數據的增長,ETL工具能夠靈活適應并擴展數據處理能力。

數據集成與共享:

ETL可以將數據從不同的源系統中提取出來,進行格式轉換和映射,然后加載到目標系統中。

這樣不同部門或業務系統可以共享和訪問這些集成的數據,促進信息的共享和協同工作。

四、ETL的應用場景

企業數據倉庫構建:

ETL是構建數據倉庫的基礎,用于從ERP、CRM、POS等業務系統中抽取數據,轉換并加載至數據倉庫。

大數據整合:

面對海量、高增長率和多樣性的大數據,ETL工具能夠高效地整合不同來源的大數據,為數據分析和機器學習提供準備好的數據集。

商務智能(BI)報告:

ETL為BI平臺提供統一、準確的數據源,支撐報表開發、儀表盤展示,幫助企業快速響應市場變化并制定策略。

數據遷移與歸檔:

在系統升級或數據存儲策略調整時,ETL用于數據的遷移和歷史數據的歸檔,確保數據的連續性和完整性。

五、開源ETL工具盤點

Kettle(水壺)

適用場景:適用于各種復雜的數據抽取、轉換和加載任務。

功能:提供圖形化的設計界面,方便用戶設計ETL轉換過程;支持批量運行和調度任務。

簡介:一款國外免費開源的ETL工具,純Java編寫,可在Windows、Linux、Unix上運行,數據抽取高效穩定。

Apache Sqoop

適用場景:適用于Hadoop與關系數據庫之間的數據同步。

功能:支持全量和增量數據抽取,提供高效的數據傳輸性能。

簡介:Apache開源的一款在Hadoop和關系數據庫服務器之間傳輸數據的工具,大數據領域常見的工具。

Apache Flume

適用場景:適用于日志數據的收集和處理。

功能:支持從多種數據源收集數據,并將其傳輸到指定的目標系統。

簡介:Apache開源的一款分布式、可靠、高可用的日志收集、聚合和傳輸系統。

Apache Nifi

適用場景:適用于數據流的處理和實時數據集成。

功能:提供可視化的數據流處理界面,支持從各種數據源抽取數據,并進行轉換和加載。

簡介:Apache開源的一款數據流處理和數據集成工具。

Logstash

適用場景:適用于日志數據的收集、轉換和發送。

功能:支持多種輸入和輸出插件,可靈活配置數據處理流程。

簡介:一款開源的服務器端數據處理管道,能夠同時從多個源采集數據,轉換數據,然后將數據發送到你指定的目的地。

Canal

適用場景:適用于MySQL等數據庫的數據實時同步。

功能:基于數據庫增量日志解析,提供增量數據實時訂閱和消費,主要支持MySQL和MariaDB。

簡介:阿里巴巴旗下的一款開源項目,純Java開發。

DataX

適用場景:適用于各種異構數據源之間的數據同步任務。

功能:實現包括MySQL、Oracle、SqlServer、Postgre、HDFS、Hive等多種異構數據源之間高效的數據同步功能。

簡介:阿里巴巴集團內被廣泛使用的離線數據同步工具/平臺。

Talend Open Studio for Data Integration

適用場景:適用于各種數據集成和管理任務。

功能:提供豐富的組件和圖形化設計界面,支持數據集成、數據質量和數據管理等功能。

簡介:Talend公司提供的開源ETL工具。

Pentaho Data Integration (PDI)

適用場景:適用于數據集成、數據轉換和數據加載等任務。

功能:提供圖形化的ETL設計界面和豐富的轉換組件,支持多種數據源和目標系統。

簡介:Hitachi Vantara提供的開源ETL工具,也被稱為Kettle的社區版。

Apache Camel

適用場景:適用于復雜的系統集成和數據傳輸任務。

功能:提供路由和中介功能,支持從各種數據源抽取數據,并進行轉換和發送。

簡介:Apache開源的一款集成框架,支持多種傳輸協議和數據格式。

綜上所述,ETL在數據倉庫系統、大數據整合、商務智能報告以及數據遷移與歸檔等場景中發揮著重要作用。通過數據抽取、轉換和加載的過程,ETL實現了數據的清洗、整合和提煉,為用戶提供了高質量的數據支持。

- 相關連接器

數環通

數環通- 相關文章推薦